De la redacción

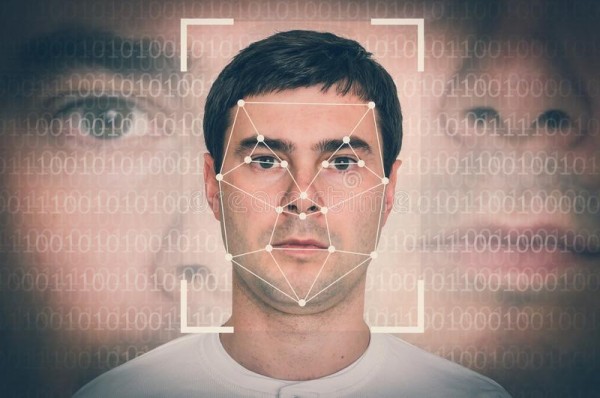

Existe una creciente preocupación en el mundo académico y en la industria de la tecnología de punta, así como entre los defensores de los derechos civiles, por la utilización de la tecnología de reconocimiento facial, por parte de agencias federales de la ley y el orden. Porque se trata de “tecnología sesgada” que se ha convertido en «un problema sistémico», que no se puede controlar adecuadamente «sin la regulación gubernamental». Un tema al Línea Abierta de Radio Bilingüe, en colaboración con The Justice Collaborative y su revista digital, The Appeal, han dado amplia y oportuna cobertura.

Este miércoles unos 25 prominentes investigadores de inteligencia artificial (A.I.), incluidos expertos en Google, Facebook y Microsoft han firmado una carta en la que piden a Amazon que deje de vender tecnología de reconocimiento facial a las agencias del orden público, porque “está sesgada” y es utilizada principalmente “en contra de las mujeres y las personas de color”, reporta hoy The New York Times.

Y es que “Amazon vende un producto llamado ‘Rekognition’, a través de su división de computación en la nube, Amazon Web Services”. De acuerdo con la fuente, “La compañía dijo el año pasado que entre los primeros clientes se encontraban el Departamento de Policía de Orlando en La Florida y la Oficina del Sheriff del Condado de Washington, en Oregon”.

Resulta que al ser sometida recientemente a revisión por expertos en el rubro, Amazon Rekognition mostró tener más problemas para identificar los rostros del género defemenino y de piel más oscura en las fotos, que otros servicios similares de IBM y Microsoft. “Se confundió a las mujeres con los hombres el 19 por ciento de las veces… y se identificó erróneamente a las mujeres de piel más oscura con hombres un 31%”, dijeron a la fuente dos investigadores del prestigioso Instituto de Tecnología de Massachusetts (M.I.T.).

Como reportamos en Línea Abierta de Radio Bilingüe, “aún sin haber conseguido el muro fronterizo” la administración Trump está consiguiendo “… algo que podría ser peor para los derechos humanos: ‘un muro inteligente’”. Y sin embargo, no resulta tan “inteligente”.

La inquietudes a cerca del producto ‘Amazon Rekognition’ planteadas por los investigadores del M.I.T. habían sido analizadas ya en un estudio similar que examinaba los servicios de IBM, Microsoft y Megvii, “una compañía de inteligencia artificial en China”, dice el Times.

Pero el 24 de enero Amazon disputó el referido estudio con un artículo de Matthew Wood y Michael Punke en el el rotativo neoyorquino: «La respuesta a las inquietudes sobre la nueva tecnología no es ejecutar pruebas inconsistentes con la forma en que el servicio está diseñado para ser utilizado, y para amplificar las conclusiones falsas y engañosas de la prueba a través de los medios de comunicación”.

No obstante, la carta publicada ayer miércoles habría sido firmada, entre otros, por los investigadores de Google, Margaret Mitchell, Andrea Frome y Timnit Gebru; por la investigadora de Facebook, Georgia Gkioxari; por William Isaac, investigador de DeepMind, un laboratorio en Londres propiedad de Alphabet, la empresa matriz de Google; y por Yoshua Bengio, una de las tres personas que recibió el Premio Turing, “a menudo llamado Premio Nobel de computación… por su trabajo con redes neuronales, la tecnología que respalda los servicios modernos de reconocimiento facial”.

La fuente señala además que tanto el Dr. Wood como Punke, de Amazon, “tergiversaron los detalles técnicos» del estudio de M.I.T. sobre esta tecnología moderna de reconocimiento facial. Pero Amazon se negó a comentar el contenido de la carta de los investigadores este miércoles.

Por el contrario, Microsoft mejoró, dice, la precisión de su reconocimiento facial el año pasado después de un estudio de M.I.T., que “informó que su sistema era mejor para identificar el género de los hombres de piel más clara en una base de datos de fotos, que las mujeres de piel más oscura”, sostiene la fuente.

Por su parte Brad Smith, presidente y director legal de Microsoft, dijo en una charla sostenida en febrero en la escuela de graduados de Cornell Tech, en Nueva York, que su empresa “había participado en el mercado de herramientas para la aplicación de la ley en Estados Unidos». Pero añadió que “había rechazado las ventas cuando supo de la preocupación” acerca de los peligros que “podía infringir injustificadamente a los derechos de las personas”. Y respaldó un proyecto de ley en el estado de Washington para exigir dar avisos en los lugares públicos donde se estuviera utilizando tecnología de reconocimiento facial”. Esto también fue abordado en su oportunidad por Edición Semanaria de Radio Bilingüe.

Así mismo Smith afirmó que “se garantizaría que las agencias gubernamentales obtuvieran una orden judicial cuando buscaran personas específicas”. El proyecto de ley todavía está pendiente, afirma el Times.

Por su parte Amazon se ha negado a revelar cómo la policía o las agencias de inteligencia están utilizando su sistema Rekognition, y si la empresa impone restricciones a su uso. Y agregó en un comunicado que “no ha recibido ningún informe sobre el uso indebido de Rekognition, por parte de la policía”, y que su política acerca del uso de dicha tecnología “prohíbe a los clientes usar sus servicios de manera que infrinjan las leyes”.

Sin embargo, como también se dijo en Línea Abierta, “el aumento en el gasto en tecnologías de vigilancia, como drones, tecnología de voz y reconocimiento facial puede ser más peligroso para los migrantes y la gente de color». Si bien algunas compañías de alta tecnología esperan sacar partido de esta bonanza y mercadean las plataformas de vigilancia al servicio de Inmigracion y Control de Aduanas, ICE, otros líderes de la industria están pidiendo leyes para regular esta tecnología y ya el gobierno de San Francisco, California ha decretado prohibiciones y al menos dos estados consideran esa vía”■

Línea Abierta: